La aplicación de algoritmos en escenarios como los enunciados ha sido fuente de varias críticas por encarnar una serie de dilemas éticos que deben evitarse en el marco social; sin embargo, las críticas más fuertes se han encontrado en el hecho de que, algunos de sus resultados, refuercen sesgos sociales históricos.

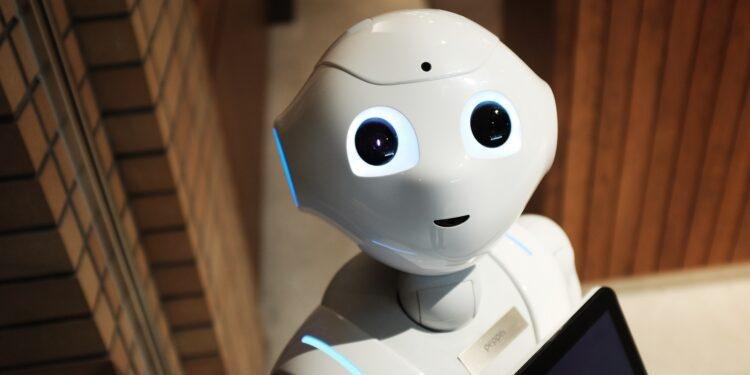

Desde hace algunas décadas la humanidad ha sido testigo del rápido desarrollo tecnológico y su igualmente veloz implementación en casi todas las áreas de nuestra vida, erigiéndose como una promesa importante y necesaria para la automatización de algunas actividades sociales y jurídicas como la prevención del crimen, predicción y prevención del abuso infantil, prevención de fraude o elección en sistemas estandarizados de contratación.

La aplicación de algoritmos en escenarios como los enunciados ha sido fuente de varias críticas por encarnar una serie de dilemas éticos que deben evitarse en el marco social; sin embargo, las críticas más fuertes se han encontrado en que, algunos de los resultados arrojados, refuerzan sesgos sociales históricos.

Con la incorporación de inteligencias artificial (AI) en procesos sociales o en áreas jurídicas, la finalidad es clara y puede resumirse en dos aspectos. En primer lugar, la automatización de funciones permite a los entes sociales y reguladores ahorrar tiempo y dinero. El recorte presupuestal ha sido el motor, en algunos casos, del impulso de eficiencia que ha derivado en herramientas automatizadas que, a su vez, permiten, en teoría, hacer más eficiente una labor.

La otra razón por la que se ha incrementado el uso de algoritmos en este tipo de actividades es la atribución generalizada que se hace a estas herramientas de cualidades que consideramos ajenas a la mayoría de los seres humanos. Se atribuye al uso de algoritmos la obtención de resultados más justos y objetivos en apenas una fracción del tiempo que le tomaría a quien o quienes regularmente se dedican a ello.

En Estados Unidos, por ejemplo, en los primeros años de la década de los noventa se buscó alcanzar un sistema penal más justo a través de técnicas automatizadas que utilizaran árboles de decisión basados en reglas predeterminadas. Actualmente, las predicciones se obtienen por el uso de técnicas como el reconocido aprendizaje automático o Machine Learning.

La ventaja que se le atribuye a Machine Learning se debe a su capacidad de identificar relaciones causales y patrones en grandes conjuntos de datos. Entonces, ¿por qué se ha criticado su aplicación en ámbitos sociales y jurídicos?

El Centro de ética de datos e innovación (Centre for Data Ethics and Innovation) del Reino Unido concluyó que el uso de instrumentos para identificar zonas propensas a la comisión de delitos generó un estado de alerta en los oficiales a la hora de patrullar en esas zonas ocasionando la detención injusta de personas.

Así, detrás de la apariencia objetiva que se le ha atribuido, los resultados obtenidos han permitido perpetuar desigualdades sociales que buscaban eliminarse con este tipo de herramientas. Podría decirse que el error está en la toma de datos sesgados y el refuerzo de ese sesgo a través de herramientas amplificadoras, lo cual permite que los datos del pasado moldeen las acciones del futuro.

Se puede intentar explicar los sesgos en el algoritmo desde un punto de vista técnico, por ejemplo, debido a la falta de representatividad en los datos utilizados; sin embargo, cuando los sesgos codificados son fuente de reproducción de injusticias sociales históricas, no puede tomarse ninguna explicación técnica como suficiente.

El problema no es, ni puede ser, la implementación de nuevas tecnologías para la obtención de datos que apoyen la actividad policial, judicial o jurídica, el problema está en los datos con los que se alimentan estos algoritmos derivados de una sociedad desigual; o quizás el problema sea la actividad predictiva aplicada al ámbito social. Desde la teoría de Lombroso hasta la actualidad, la predicción como método de prevención de delitos se ha mostrado notablemente menos eficaz de lo que se esperaba.

Los beneficios de la IA sólo podrán obtenerse, en este tipo de escenarios, cuando su uso no tenga un alcance predictivo, o cuando teniéndolo, no implique la perpetuación de injusticias sociales históricas, para lo cual se necesita una evaluación de los datos utilizados para alimentar o entrenar herramientas predictivas que, a su vez, hace necesaria la participación de diferentes actores de la economía que conozcan el contexto social de los datos tomados y las condiciones socioeconómicas del lugar donde se pretende aplicar la herramienta predictiva buscando garantizar equidad en los resultados de estas herramientas.